AlphaGo是一个有“深度学习”能力的人工智能系统,利用深度学习算法,能够吸收知识改进自身——包括神经网络的拓扑结构和神经元的权重与阈值。这意味着,AlphaGo今天可以学习下围棋,明天也许就可以学习玩“飞机大战”、学习画油画等等。这种模拟人类的学习能力,才是AlphaGo真正的厉害之处。

让我们来看看AlphaGo是怎样成为围棋高手的。

“AlphaGo系统主要由四个部分组成:

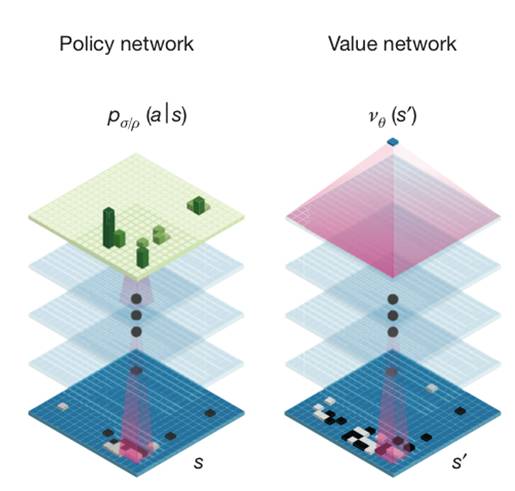

1. 走棋网络(Policy Network,也译为策略网络),给定当前局面,预测/采样下一步的走棋。

2. 快速走子(Fast rollout),目标和1一样,但在适当牺牲走棋质量的条件下,速度要比1快1000倍。

3. 估值网络(Value Network),给定当前局面,估计是白胜还是黑胜。

4. 蒙特卡罗树搜索(Monte Carlo Tree Search,MCTS),把以上这三个部分连起来,形成一个完整的系统。”

——田渊栋(卡耐基梅隆大学机器人系博士,Facebook人工智能组研究员)

其中,“走棋网络”(也称策略网络)会对全局进行把控,先剔除一些多余选项——面对眼前的一盘棋,有些棋步是明显不该走的,比如不该随便送子给别人吃。而“估值网络”(也称价值网络)会对棋路的价值进行评估——AlphaGo会一边推算一边判断局面,在局面处于明显劣势的时候,再集中进行推算的价值已经不高,可以果断放弃,避免了“一条道走到死”的局面;利用蒙特卡洛算法,将这些信息放入一个概率函数,AI就不用给每一步以同样的重视程度,而可以重点分析那些“含金量”较高的地方。

策略网络和价值网络是两种深度神经网络,简单来说,策略网络负责减少搜索的宽度,价值网络负责减少搜索的深度,从而将系统的计算量控制在可以接受的范围内。

AlphaGo之父——杰米斯•哈萨比斯(Demis Hassabis),AlphaGo研发公司“Deep Mind”创始人